PCA

La Principal Component Analysis, o trasformazione discreta di Karhunen-Loeve KLT, è una tecnica che ha due importanti applicazioni nell'analisi dei dati:

- permette di “ordinare” in una distribuzione vettoriale dei dati in modo da massimizzarne la varianza e, attraverso questa informazione, ridurre le dimensioni del problema: si tratta pertanto di una tecnica di compressione dei dati a perdita, o altrimenti una tecnica per rappresentare con meno dati la medesima quantità di informazione;

- trasforma i dati in ingresso in modo che la matrice di covarianza dei dati in uscita sia diagonale e pertanto le componenti dei dati siano tra loro scorrelate.

Allo stesso modo esistono due formulazioni della definizione di PCA:

- proietta i dati su uno spazio a dimensione inferiore tale che la varianza dei dati proiettati sia massima;

- proietta i dati su uno spazio a dimensione inferiore tale che la distanza tra il punto e la sua proiezione sia minima.

Un esempio pratico di riduzione delle dimensioni di un problema è l'equazione di un iperpiano in  dimensioni: esiste una base dello spazio che trasforma l'equazione del piano riducendola a

dimensioni: esiste una base dello spazio che trasforma l'equazione del piano riducendola a  dimensioni senza perdere informazione, facendo risparmiare così una dimensione al problema.

dimensioni senza perdere informazione, facendo risparmiare così una dimensione al problema.

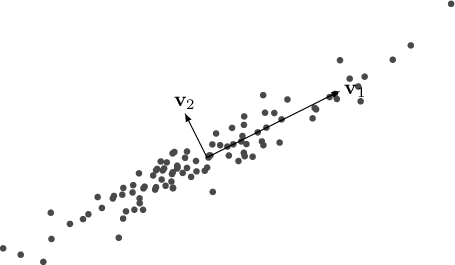

Figura 2.2:

Componenti Principali.

|

|

Siano pertanto

vettori aleatori rappresentanti i risultati di un qualche esperimento, realizzazioni di una variabile aleatoria a media nulla, che possono essere memorizzati nelle righe2.1 della matrice

vettori aleatori rappresentanti i risultati di un qualche esperimento, realizzazioni di una variabile aleatoria a media nulla, che possono essere memorizzati nelle righe2.1 della matrice  di dimensioni

di dimensioni  , matrice pertanto che memorizza

, matrice pertanto che memorizza  vettori aleatori di dimensionalità

vettori aleatori di dimensionalità  e con

e con  .

Ogni riga corrisponde a un diverso risultato

.

Ogni riga corrisponde a un diverso risultato  e la distribuzione di questi esperimenti deve avere media, quantomeno quella empirica, nulla.

e la distribuzione di questi esperimenti deve avere media, quantomeno quella empirica, nulla.

Assumendo che i punti abbiano media zero (cosa che si può sempre ottenere con la semplice sottrazione del centroide), la loro covarianza delle occorrenze di  è data da

è data da

|

(2.71) |

Se i dati in ingresso  sono correlati, la matrice di covarianza

sono correlati, la matrice di covarianza

non è una matrice diagonale.

non è una matrice diagonale.

L'obiettivo di PCA è trovare una trasformazione  ottima che trasformi i dati da correlati a decorrelati

ottima che trasformi i dati da correlati a decorrelati

|

(2.72) |

ed ordinati in base al loro contenuto informativo in maniera tale che, se preso un sottoinsieme delle basi, possa tale approccio ridurre la dimensione del problema.

Se esiste una base ortonormale  , tale che la matrice di covarianza di

, tale che la matrice di covarianza di

espressa con questa base sia diagonale, allora gli assi di questa nuova base si chiamano componenti principali di

espressa con questa base sia diagonale, allora gli assi di questa nuova base si chiamano componenti principali di

(o della distribuzione di

(o della distribuzione di  ).

Quando si ottiene una matrice di covarianza dove tutti gli elementi sono

).

Quando si ottiene una matrice di covarianza dove tutti gli elementi sono  tranne che sulla diagonale, significa che sotto questa nuova base dello spazio gli eventi sono tra loro scorrelati.

tranne che sulla diagonale, significa che sotto questa nuova base dello spazio gli eventi sono tra loro scorrelati.

Questa trasformazione può essere trovata risolvendo un problema agli autovalori: si può infatti dimostrare che gli elementi della matrice di correlazione diagonale devono essere gli autovalori di  e per questa ragione le varianze della proiezione del vettore

e per questa ragione le varianze della proiezione del vettore  sulle componenti principali sono gli autovalori stessi:

sulle componenti principali sono gli autovalori stessi:

|

(2.73) |

dove  è la matrice degli autovettori (matrice ortogonale

è la matrice degli autovettori (matrice ortogonale

) e

) e

è la matrice diagonale degli autovalori

è la matrice diagonale degli autovalori

.

.

Per ottenere questo risultato esistono due approcci.

Siccome

è una matrice simmetrica, reale, definita positiva, può essere scomposta in

è una matrice simmetrica, reale, definita positiva, può essere scomposta in

|

(2.74) |

chiamata decomposizione spettrale, con  matrice ortonormale, autovalori destri di

matrice ortonormale, autovalori destri di

, e

, e

è la matrice diagonale che contiene gli autovalori. Siccome la matrice

è la matrice diagonale che contiene gli autovalori. Siccome la matrice

è definita positiva, tutti gli autovalori saranno positivi o nulli. Moltiplicando a destra l'equazione (2.74) per

è definita positiva, tutti gli autovalori saranno positivi o nulli. Moltiplicando a destra l'equazione (2.74) per  si mostra che è esattamente la soluzione del problema (2.73).

si mostra che è esattamente la soluzione del problema (2.73).

Tale tecnica tuttavia richiede il calcolo esplicito di

.

Data una matrice rettangolare

.

Data una matrice rettangolare  , la tecnica SVD permette esattamente di trovare gli autovalori e gli autovettori della matrice

, la tecnica SVD permette esattamente di trovare gli autovalori e gli autovettori della matrice

ovvero di

ovvero di

e pertanto è la tecnica più efficiente e numericamente stabile per ottenere questo risultato.

Attraverso la SVD è possibile decomporre la matrice degli eventi

e pertanto è la tecnica più efficiente e numericamente stabile per ottenere questo risultato.

Attraverso la SVD è possibile decomporre la matrice degli eventi  in modo che

in modo che

usando come rappresentazione la Economy/Compact SVD dove  sono gli autovettori sinistri (left singular vectors),

sono gli autovettori sinistri (left singular vectors),  gli autovalori di

gli autovalori di

e

e  gli autovettori destri.

È da notare che usando la SVD non è necessario calcolare esplicitamente la matrice di covarianza

gli autovettori destri.

È da notare che usando la SVD non è necessario calcolare esplicitamente la matrice di covarianza

. Tale matrice può essere tuttavia ricavata in un secondo momento attraverso l'equazione

. Tale matrice può essere tuttavia ricavata in un secondo momento attraverso l'equazione

|

(2.75) |

Confrontando questa relazione con quella di equazione (2.74) si ottiene anche che

.

.

Vanno ricordate le proprietà degli autovalori:

- Gli autovalori di

e di

e di

sono i medesimi.

sono i medesimi.

- I valori singolari sono gli autovalori della matrice

, ovvero la matrice di covarianza;

, ovvero la matrice di covarianza;

- Gli autovalori maggiori sono associati ai vettori direzione di massima varianza;

e anche una importante proprietà della SVD

|

(2.76) |

che è l'approssimazione di rango  più vicina a

più vicina a  . Questo fatto, unito alla caratteristica propria di SVD di ritornare i valori singolari di

. Questo fatto, unito alla caratteristica propria di SVD di ritornare i valori singolari di  ordinati dal maggiore al minore, permette l'approssimazione di una matrice a una di rango inferiore.

ordinati dal maggiore al minore, permette l'approssimazione di una matrice a una di rango inferiore.

Selezionando il numero di autovettori con autovalori abbastanza grandi è possibile creare una base ortonormale  dello spazio

dello spazio

tale che

tale che

ottenuto come proiezione

ottenuto come proiezione

rappresenti uno spazio di dimensioni ridotte ma che comunque contenga la maggior parte dell'informazione del sistema.

Figura 2.3:

Esempio dei primi 10 autovettori  estratti dal dataset di pedoni Daimler-DB

estratti dal dataset di pedoni Daimler-DB

|

|

Footnotes

- 2.1

- In questo documento si è scelta la convezione per righe: in letteratura si trova in ugual maniera la rappresentazione per riga o per colonna dei dati e di conseguenza la nomenclatura potrebbe essere differente e far riferimento a

invece che a

invece che a  e viceversa.

e viceversa.

Paolo medici

2025-10-02

sono correlati, la matrice di covarianza

sono correlati, la matrice di covarianza

non è una matrice diagonale.

non è una matrice diagonale.

è la matrice degli autovettori (matrice ortogonale

è la matrice degli autovettori (matrice ortogonale

) e

) e

è la matrice diagonale degli autovalori

è la matrice diagonale degli autovalori

.

.

matrice ortonormale, autovalori destri di

matrice ortonormale, autovalori destri di

, e

, e

è la matrice diagonale che contiene gli autovalori. Siccome la matrice

è la matrice diagonale che contiene gli autovalori. Siccome la matrice

è definita positiva, tutti gli autovalori saranno positivi o nulli. Moltiplicando a destra l'equazione (2.74) per

è definita positiva, tutti gli autovalori saranno positivi o nulli. Moltiplicando a destra l'equazione (2.74) per  si mostra che è esattamente la soluzione del problema (2.73).

si mostra che è esattamente la soluzione del problema (2.73).

sono gli autovettori sinistri (left singular vectors),

sono gli autovettori sinistri (left singular vectors),  gli autovalori di

gli autovalori di

e

e  gli autovettori destri.

È da notare che usando la SVD non è necessario calcolare esplicitamente la matrice di covarianza

gli autovettori destri.

È da notare che usando la SVD non è necessario calcolare esplicitamente la matrice di covarianza

. Tale matrice può essere tuttavia ricavata in un secondo momento attraverso l'equazione

. Tale matrice può essere tuttavia ricavata in un secondo momento attraverso l'equazione

.

.

e di

e di

sono i medesimi.

sono i medesimi.

, ovvero la matrice di covarianza;

, ovvero la matrice di covarianza;

più vicina a

più vicina a  . Questo fatto, unito alla caratteristica propria di SVD di ritornare i valori singolari di

. Questo fatto, unito alla caratteristica propria di SVD di ritornare i valori singolari di  ordinati dal maggiore al minore, permette l'approssimazione di una matrice a una di rango inferiore.

ordinati dal maggiore al minore, permette l'approssimazione di una matrice a una di rango inferiore.

invece che a

invece che a  e viceversa.

e viceversa.